CogVideoX-5b 是由清华大学和智谱 AI 联合开发的开源多模态视频生成大模型,基于 3D 变分自编码器(3D VAE)和扩散变换器(DiT)架构。该模型支持中英文文本到视频的生成,能够生成时长 6 秒、分辨率 720x480、帧率 8fps 的高质量视频内容。本文档详细介绍如何从源码进行本地化部署和配置优化。

系统要求

核心技术规格

CogVideoX-5b 是一个拥有 50 亿参数 的视频生成模型,采用了以下核心技术:

- 模型架构: 3D 变分自编码器 (3D VAE) + 扩散变换器 (DiT)

- 输出规格: 6 秒视频,720×480 分辨率,8fps 帧率,共 49 帧

- 语言支持: 中文和英文双语文本提示词

- 推理精度: 支持 FP16 和 BF16 混合精度推理

硬件要求详解

GPU 显存需求分析

不同使用场景的显存要求:

| 使用模式 | 最低显存 | 推荐显存 | 推荐 GPU 型号 | 生成质量 |

|---|---|---|---|---|

| 快速体验 | 8GB | 12GB | RTX 4070, RTX 3080 | 基础质量 (13 帧) |

| 标准使用 | 12GB | 18GB | RTX 4080, RTX 4070Ti | 标准质量 (25 帧) |

| 最佳质量 | 18GB | 24GB+ | RTX 4090, A100, H100 | 高质量 (49 帧) |

注意: 实际显存占用会根据生成参数动态变化。启用内存优化功能可降低约 20-30% 的显存需求。

系统配置要求

- CPU: Intel i5-8400 / AMD Ryzen 5 3600 或更高

- 内存:

- 最低: 16GB (仅限快速体验模式)

- 推荐: 32GB (标准使用)

- 最佳: 64GB+ (高质量生成 + 多任务处理)

- 存储:

- 系统盘: 至少 20GB 可用空间

- 模型存储: 50GB+ (CogVideoX-5b 模型约 18GB)

- 输出空间: 建议预留 50GB+ (生成的视频文件)

- CUDA: 支持 CUDA 11.8、12.1、12.8+ (必须与 PyTorch 版本匹配)

网络要求

- 初次部署: 稳定网络连接,用于下载 18GB 模型文件

- 镜像加速: 建议配置 HuggingFace 镜像源 (如 hf-mirror.com)

- 带宽建议: 100Mbps+ (加快模型下载速度)

软件环境要求

Python 环境

- Python 版本: 3.8 - 3.11 (推荐 3.10)

- 包管理器: pip 或 conda (推荐使用 conda 进行环境隔离)

深度学习框架

- PyTorch: 2.0.0+ (必须支持 CUDA)

- 核心依赖:

diffusers >= 0.30.0(视频生成管道)transformers >= 4.44.0(文本编码器)accelerate >= 0.20.0(分布式训练支持)

性能预估

生成时间参考 (单个视频)

| GPU 型号 | 13 帧模式 | 25 帧模式 | 49 帧模式 |

|---|---|---|---|

| RTX 4090 | ~1-2 分钟 | ~2-3 分钟 | ~4-6 分钟 |

| RTX 4080 | ~2-3 分钟 | ~3-5 分钟 | ~6-9 分钟 |

| RTX 4070 | ~3-5 分钟 | ~5-8 分钟 | ~10-15 分钟 |

| A100 | ~1 分钟 | ~1-2 分钟 | ~2-4 分钟 |

提示: 实际生成时间受提示词复杂度、推理步数等参数影响。首次运行需要额外的模型加载时间。

部署步骤

1. 环境准备

# 创建conda环境

conda create -n cogvideox python=3.10 -y

conda activate cogvideox

# 安装CUDA相关依赖

# CUDA 11.8

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# CUDA 12.1+(包括12.8)

# pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

CUDA 版本确认

在安装 PyTorch 之前,请确认您的 CUDA 版本:

# 检查CUDA版本

nvidia-smi

2. 安装依赖

直接安装所需的 Python 依赖包:

# 安装核心依赖包

pip install diffusers[torch]>=0.30.0

pip install transformers>=4.44.0

pip install accelerate>=0.20.0

pip install imageio-ffmpeg

pip install safetensors

pip install sentencepiece

依赖包说明

| 包名 | 版本要求 | 作用 |

|---|---|---|

diffusers | >=0.30.0 | 视频生成管道核心库 |

transformers | >=4.44.0 | 文本编码器 |

accelerate | >=0.20.0 | 模型加速和内存优化 |

imageio-ffmpeg | 最新 | 视频文件处理 |

safetensors | 最新 | 安全的模型文件格式 |

sentencepiece | 最新 | 文本分词器 |

验证依赖安装

# 验证关键包是否正确安装

python -c "import torch; print('PyTorch:', torch.__version__)"

python -c "import diffusers; print('Diffusers:', diffusers.__version__)"

python -c "from diffusers import CogVideoXPipeline; print('CogVideoX 可用')"

python -c "from diffusers.utils import export_to_video; print('export_to_video 可用')"

3. 下载模型

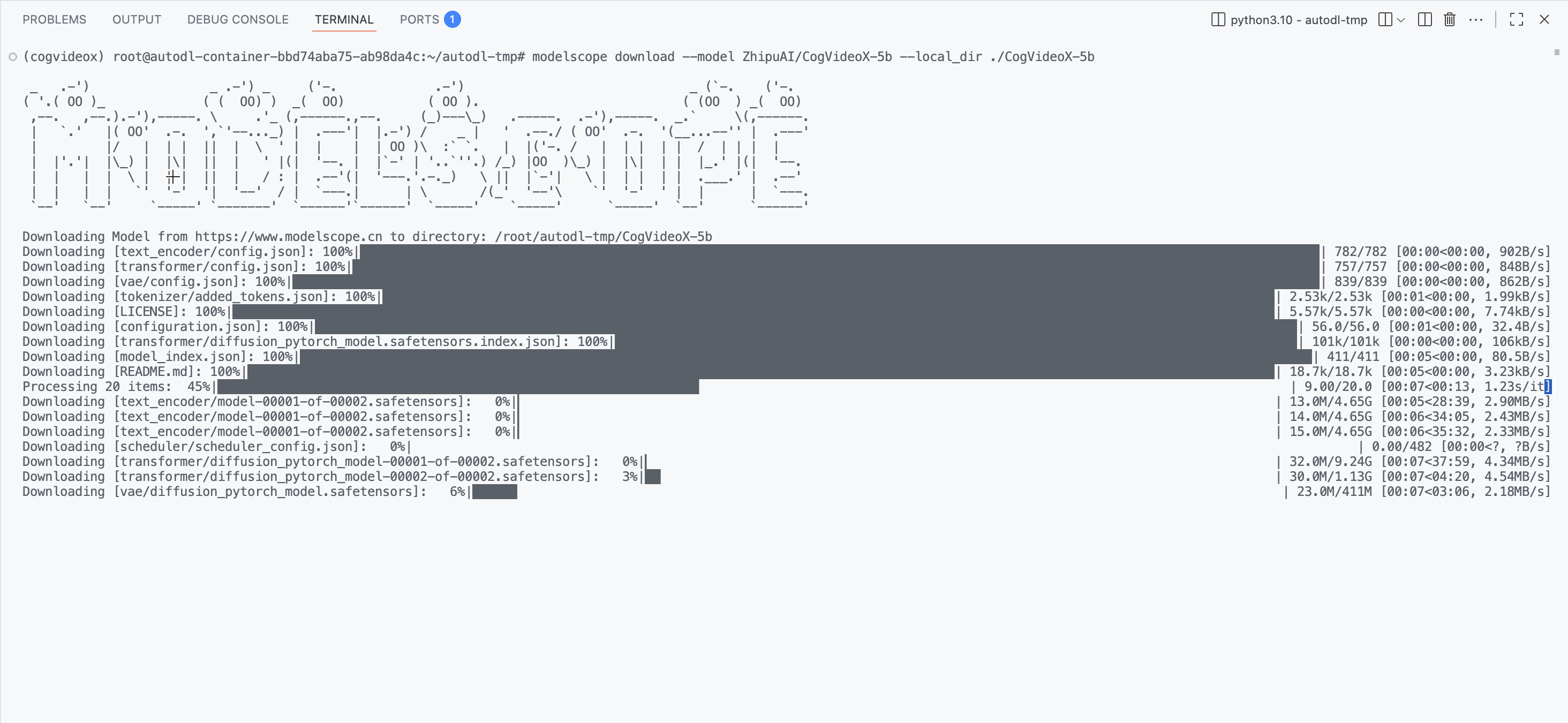

方法一:ModelScope 下载(推荐)

# 如果还没安装ModelScope

pip install modelscope

# 下载CogVideoX-5b模型

modelscope download --model ZhipuAI/CogVideoX-5b --local_dir ./models/CogVideoX-5b

# 验证下载完成

ls -la ./models/CogVideoX-5b/

方法二:HuggingFace 下载

# 安装huggingface-hub CLI工具

pip install huggingface_hub[cli]

# 下载模型

huggingface-cli download THUDM/CogVideoX-5b --local-dir ./models/CogVideoX-5b

# 设置镜像加速(可选,国内用户)

export HF_ENDPOINT=https://hf-mirror.com

huggingface-cli download THUDM/CogVideoX-5b --local-dir ./models/CogVideoX-5b

4. 创建环境检查脚本

创建 check_environment.py 文件,用于检查系统环境和依赖包:

import torch

import os

def main():

print("CogVideoX-5b 环境检查")

print("=" * 30)

# 检查PyTorch和CUDA

print(f"PyTorch版本: {torch.__version__}")

print(f"CUDA可用: {torch.cuda.is_available()}")

if torch.cuda.is_available():

gpu_name = torch.cuda.get_device_name(0)

gpu_memory = torch.cuda.get_device_properties(0).total_memory / (1024**3)

print(f"GPU: {gpu_name}")

print(f"显存: {gpu_memory:.1f} GB")

if gpu_memory < 16:

print("⚠️ 显存可能不足,建议16GB+")

else:

print("✅ 显存充足")

else:

print("❌ 未检测到CUDA GPU")

# 检查关键依赖

try:

from diffusers import CogVideoXPipeline

from diffusers.utils import export_to_video

print("✅ diffusers 可用")

except ImportError:

print("❌ diffusers 未正确安装")

return False

# 检查模型

model_path = "./models/CogVideoX-5b"

if os.path.exists(model_path):

print("✅ 模型文件存在")

else:

print("❌ 模型文件不存在")

print("请先下载模型:")

print("modelscope download --model ZhipuAI/CogVideoX-5b --local_dir ./models/CogVideoX-5b")

return False

print("\n✅ 环境检查完成,可以开始生成视频!")

return True

if __name__ == "__main__":

main()

5. 创建视频生成脚本

创建 generate_video.py 文件,基于简化的视频生成脚本:

import torch

from diffusers import CogVideoXPipeline

from diffusers.utils import export_to_video

# 英文提示词示例

prompt = "A panda, dressed in a small, red jacket and a tiny hat, sits on a wooden stool in a serene bamboo forest. The panda's fluffy paws strum a miniature acoustic guitar, producing soft, melodic tunes. Nearby, a few other pandas gather, watching curiously and some clapping in rhythm. Sunlight filters through the tall bamboo, casting a gentle glow on the scene. The panda's face is expressive, showing concentration and joy as it plays. The background includes a small, flowing stream and vibrant green foliage, enhancing the peaceful and magical atmosphere of this unique musical performance."

# 中文提示词示例(可替换上面的 prompt)

# prompt = "一只大熊猫穿着红色小外套和帽子,坐在竹林中的木凳上弹吉他,周围其他熊猫在观看和拍手,阳光透过竹叶洒下,溪流在背景中流淌,画面宁静美好"

# 加载模型

pipe = CogVideoXPipeline.from_pretrained(

"models/CogVideoX-5b", torch_dtype=torch.bfloat16

)

# 内存优化设置

pipe.enable_sequential_cpu_offload() # 将部分模型卸载到CPU

pipe.vae.enable_tiling() # 启用VAE分块处理

pipe.vae.enable_slicing() # 启用VAE切片处理

# 生成视频

video = pipe(

prompt=prompt,

num_videos_per_prompt=1, # 生成视频数量

num_inference_steps=50, # 推理步数(影响质量和速度)

num_frames=49, # 视频帧数(49帧=6秒@8fps)

guidance_scale=6, # 引导尺度(控制与提示词的贴合度)

generator=torch.Generator(device="cuda").manual_seed(42), # 随机种子

).frames[0]

# 保存视频

export_to_video(video, "output.mp4", fps=8)

print("✅ 视频生成完成: output.mp4")

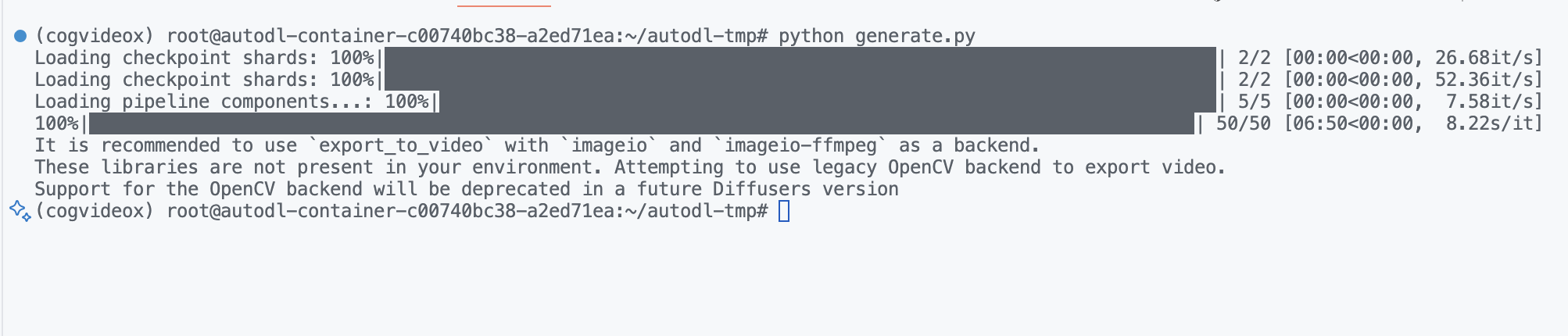

6. 使用方法

基本使用流程

# 第一步:检查环境(包含模型检查)

python check_environment.py

# 第二步:直接运行视频生成脚本

python generate_video.py

自定义提示词

如需使用自定义提示词,请编辑 generate_video.py 文件中的 prompt 变量:

# 修改这一行为您想要的提示词

prompt = "您的自定义提示词"

参数调整说明

可以在 generate_video.py 中调整以下参数:

| 参数 | 默认值 | 说明 | 内存影响 |

|---|---|---|---|

num_inference_steps | 50 | 推理步数(质量 vs 速度) | 低 |

num_frames | 49 | 视频帧数 (13/25/49) | 高 |

guidance_scale | 6 | 引导尺度(提示词贴合度) | 低 |

torch_dtype | bfloat16 | 数据类型(bfloat16/float16) | 中 |

generator.manual_seed | 42 | 随机种子(控制结果一致性) | 无 |

内存优化提示:脚本已启用所有内存优化功能。如遇显存不足,可降低

num_frames至 25 或 13。

生成示例

默认脚本将生成一个熊猫音乐家的视频:

执行结果如下:

性能提示:使用

torch.bfloat16精度和内存优化技术,在 RTX 4090 上生成 49 帧视频约需 5-10 分钟。