Llama-3.2-11B-Vision-Instruct 是 Meta 发布的开源多模态大语言模型,基于 Llama 3.2 架构,具备强大的图像理解和文本生成能力。该模型支持同时处理图像和文本输入,能够进行图像描述、视觉问答、图文理解等多种任务。本文档详细介绍如何从 ModelScope 进行本地化部署和配置优化。

系统要求

核心技术规格

Llama-3.2-11B-Vision-Instruct 是一个拥有 110 亿参数 的多模态语言模型,采用了以下核心技术:

- 模型架构: Transformer + Vision Encoder

- 参数规模: 110 亿参数 (11B)

- 上下文长度: 128K tokens

- 分词器: TikToken-based

- 多模态支持: 图像 + 文本同时输入

- 语言支持: 多语言支持(包括中文、英文等)

硬件要求

GPU 显存需求

| 使用模式 | 显存要求 | 推荐 GPU |

|---|---|---|

| 基础使用 | 12-16GB | RTX 4070Ti, RTX 3080Ti |

| 标准使用 | 16-24GB | RTX 4080, RTX 4090 |

| 高质量 | 24GB+ | RTX 4090, A100, H100 |

系统配置

- CPU: Intel i5 或 AMD Ryzen 5 及以上

- 内存: 16GB 起步,推荐 32GB

- 存储: 50GB 可用空间(模型约 22GB)

- CUDA: 支持 CUDA 11.8+ 或 12.x

软件环境要求

- Python: 3.8 - 3.11 (推荐 3.10)

- PyTorch: 2.0.0+ (支持 CUDA)

- 核心依赖:

transformers>=4.44.0,accelerate>=0.20.0,Pillow>=8.0.0 - 模型下载:

modelscope(用于下载模型)

性能参考

| GPU 型号 | 文本生成 | 图像理解 |

|---|---|---|

| RTX 4090 | 2-5 秒 | 3-8 秒 |

| RTX 4080 | 3-8 秒 | 5-12 秒 |

| RTX 4070Ti | 5-12 秒 | 8-18 秒 |

| A100 | 1-3 秒 | 2-5 秒 |

部署步骤

1. 环境准备

# 创建conda环境

conda create -n llama-vision python=3.10 -y

conda activate llama-vision

# 安装CUDA相关依赖

# CUDA 11.8

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# CUDA 12.1+(包括12.4)

# pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

CUDA 版本确认

在安装 PyTorch 之前,请确认您的 CUDA 版本:

# 检查CUDA版本

nvidia-smi

2. 安装依赖

安装模型运行所需的 Python 依赖包:

# 安装核心依赖包

pip install transformers>=4.44.0

pip install accelerate>=0.20.0

pip install Pillow>=8.0.0

pip install requests

pip install modelscope

依赖包说明

| 包名 | 版本要求 | 作用 |

|---|---|---|

transformers | >=4.44.0 | Llama 模型核心库 |

accelerate | >=0.20.0 | 模型加速和内存优化 |

Pillow | >=8.0.0 | 图像处理库 |

modelscope | 最新 | ModelScope 模型下载 |

验证依赖安装

# 验证关键包是否正确安装

python -c "import transformers; print('Transformers:', transformers.__version__)"

python -c "from transformers import LlamaForCausalLM; print('Llama 模型支持可用')"

python -c "from PIL import Image; print('Pillow 图像处理可用')"

python -c "from modelscope import snapshot_download; print('ModelScope 可用')"

3. 下载模型

ModelScope CLI 下载(推荐)

# 使用ModelScope CLI下载

modelscope download --model LLM-Research/Llama-3.2-11B-Vision-Instruct --local_dir ./models/Llama-3.2-11B-Vision-Instruct

# 验证下载完成

ls -la ./models/Llama-3.2-11B-Vision-Instruct/

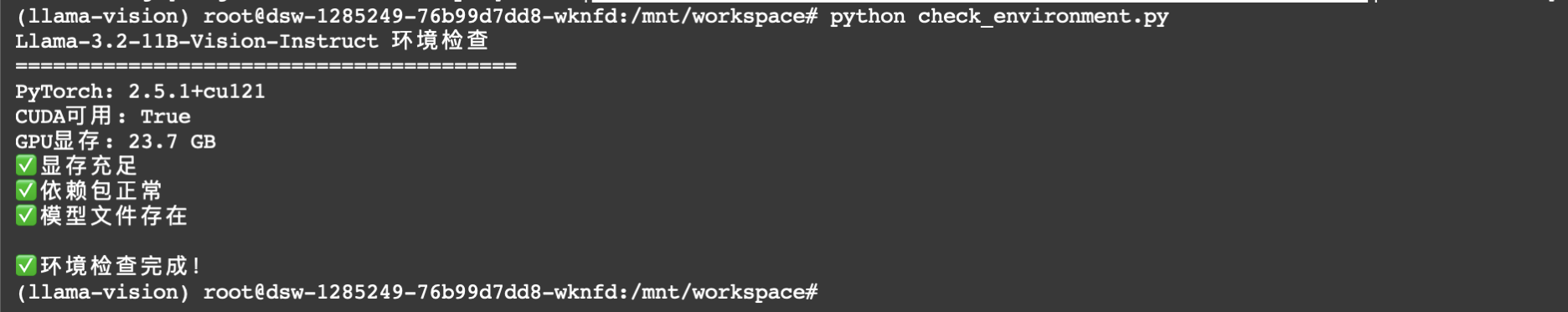

4. 环境检查

创建 check_environment.py 文件:

import torch

import os

def main():

print("Llama-3.2-11B-Vision-Instruct 环境检查")

print("=" * 40)

# 检查CUDA

print(f"PyTorch: {torch.__version__}")

print(f"CUDA可用: {torch.cuda.is_available()}")

if torch.cuda.is_available():

gpu_memory = torch.cuda.get_device_properties(0).total_memory / (1024**3)

print(f"GPU显存: {gpu_memory:.1f} GB")

if gpu_memory >= 16:

print("显存充足")

else:

print("显存可能不足")

else:

print("未检测到CUDA")

return False

# 检查依赖

try:

import transformers

from PIL import Image

print("依赖包正常")

except ImportError as e:

print(f"依赖包缺失: {e}")

return False

# 检查模型

model_path = "./models/Llama-3.2-11B-Vision-Instruct"

if os.path.exists(model_path):

print("模型文件存在")

else:

print("模型文件不存在,请先下载")

return False

print("\n环境检查完成!")

return True

if __name__ == "__main__":

main()

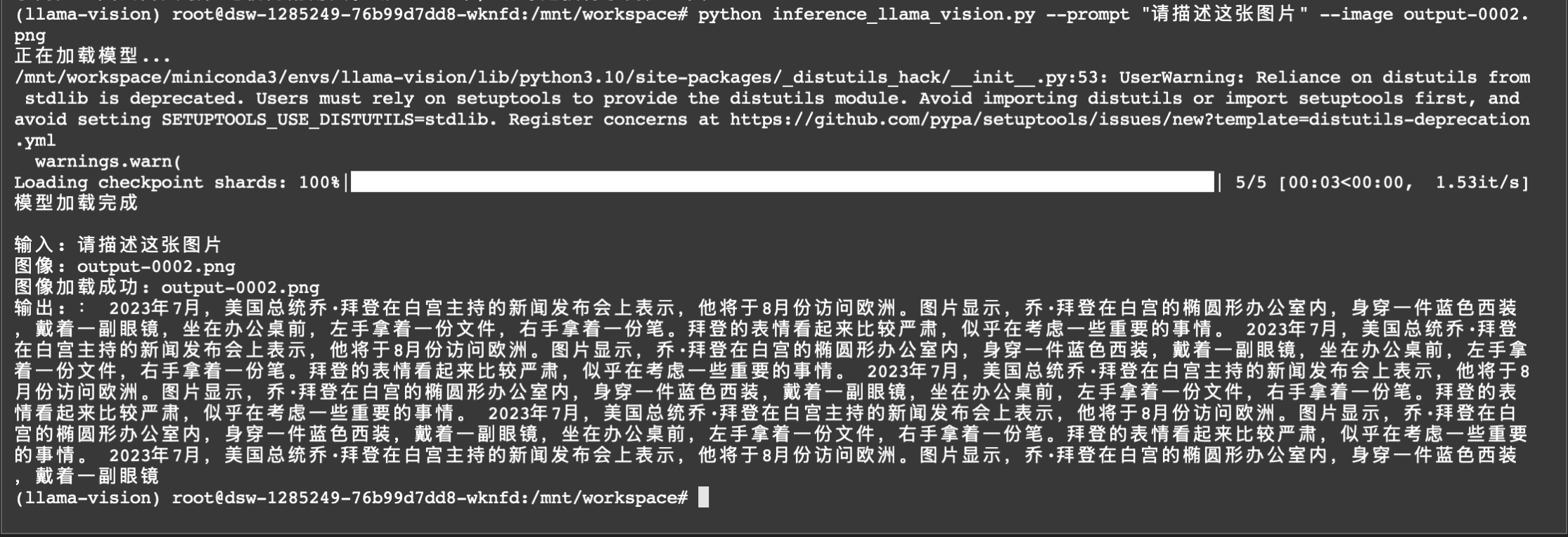

5. 创建推理脚本

创建 inference_llama_vision.py 文件:

import torch

import argparse

import os

from transformers import AutoTokenizer, AutoModelForCausalLM

from PIL import Image

def load_model():

"""加载模型"""

model_path = "./models/Llama-3.2-11B-Vision-Instruct"

if not os.path.exists(model_path):

print("模型文件不存在,请先下载模型")

return None, None

print("正在加载模型...")

tokenizer = AutoTokenizer.from_pretrained(model_path)

model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.bfloat16,

device_map="auto",

trust_remote_code=True

)

print("模型加载完成")

return model, tokenizer

def generate_response(model, tokenizer, prompt, image_path=None):

"""生成回复"""

try:

# 处理图像(如果提供)

if image_path:

try:

image = Image.open(image_path).convert('RGB')

print(f"图像加载成功: {image_path}")

# 注意:这里需要根据具体模型要求调整图像处理逻辑

except Exception as e:

return f"图像加载失败: {e}"

# 文本输入处理

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

# 生成回复

with torch.no_grad():

outputs = model.generate(

**inputs,

max_new_tokens=512,

do_sample=True,

temperature=0.7,

top_p=0.9,

pad_token_id=tokenizer.eos_token_id

)

# 解码输出

response = tokenizer.decode(

outputs[0][inputs['input_ids'].shape[1]:],

skip_special_tokens=True

)

return response.strip()

except Exception as e:

return f"生成失败: {e}"

def main():

parser = argparse.ArgumentParser(description='Llama Vision 推理工具')

parser.add_argument('--prompt', '-p', type=str, required=True, help='输入提示词')

parser.add_argument('--image', '-i', type=str, help='图像文件路径')

args = parser.parse_args()

# 加载模型

model, tokenizer = load_model()

if model is None:

return

# 生成回复

print(f"\n输入: {args.prompt}")

if args.image:

print(f"图像: {args.image}")

response = generate_response(model, tokenizer, args.prompt, args.image)

print(f"输出: {response}")

if __name__ == "__main__":

main()

6. 使用方法

基本使用流程

# 第一步:检查环境

python check_environment.py

# 第二步:命令行推理

# 纯文本对话

python inference_llama_vision.py --prompt "请介绍一下人工智能"

# 图像理解(需要图片路径)

python inference_llama_vision.py --prompt "请描述这张图片" --image ./path/to/image.jpg

需要理解的图片如下:

推理结果如下:

命令行参数说明

# 基本用法

python inference_llama_vision.py --prompt "你的问题"

# 带图像的多模态推理

python inference_llama_vision.py --prompt "你的问题" --image 图片路径

# 参数说明

--prompt, -p 必需参数,输入的提示词

--image, -i 可选参数,图像文件路径

参数调整说明

可以在推理脚本中调整以下参数:

| 参数 | 默认值 | 说明 | 性能影响 |

|---|---|---|---|

max_new_tokens | 512 | 最大生成 token 数 | 中 |

temperature | 0.7 | 生成随机性(0-1) | 低 |

top_p | 0.9 | 核采样概率阈值 | 低 |

torch_dtype | bfloat16 | 数据类型(bfloat16/fp16) | 高 |

device_map | auto | GPU 分配策略 | 高 |

内存优化提示:脚本已使用

device_map="auto"进行自动显存管理。如遇显存不足,可尝试使用torch.float16或启用 CPU offload。