Llama-3.2-11B-Vision-Instruct-GGUF 是 Meta Llama 3.2 多模态模型的 GGUF 量化版本,通过 Ollama 可以实现高效的本地部署和视觉问答功能。GGUF 格式具有更小的模型体积、更快的加载速度和更低的内存占用,非常适合在资源受限的环境中运行多模态大语言模型。

系统要求

核心技术规格

Llama-3.2-11B-Vision-Instruct-GGUF 采用了以下核心技术:

- 模型架构: Transformer + Vision Encoder (GGUF 量化)

- 参数规模: 110 亿参数 (11B,量化后约 6-8GB)

- 量化格式: GGUF (GPT-Generated Unified Format)

- 上下文长度: 128K tokens

- 多模态支持: 图像 + 文本同时输入

- 语言支持: 多语言支持(包括中文、英文等)

- 部署工具: Ollama (推荐) 或 llama.cpp

硬件要求

- CPU: Intel i5 或 AMD Ryzen 5 及以上

- 内存: 8GB 起步,推荐 16GB+

- 存储: 20GB 可用空间

- GPU: 可选,支持 CUDA、Metal(macOS)、OpenCL

软件环境要求

- 操作系统: Linux、macOS、Windows

- Ollama: >= 0.3.0

性能参考

| 配置 | 文本生成 | 图像理解 | 推理后端 |

|---|---|---|---|

| CPU (16GB RAM) | 10-30 秒 | 15-45 秒 | llama.cpp |

| RTX 4070Ti | 3-8 秒 | 5-12 秒 | CUDA |

| RTX 4090 | 2-5 秒 | 3-8 秒 | CUDA |

| M2 Pro (macOS) | 5-15 秒 | 8-20 秒 | Metal |

| M3 Max (macOS) | 3-10 秒 | 5-15 秒 | Metal |

部署步骤

1. 安装 Ollama

Linux 安装

# 使用官方安装脚本(适用于所有 Linux 发行版)

curl -fsSL https://ollama.com/install.sh | sh

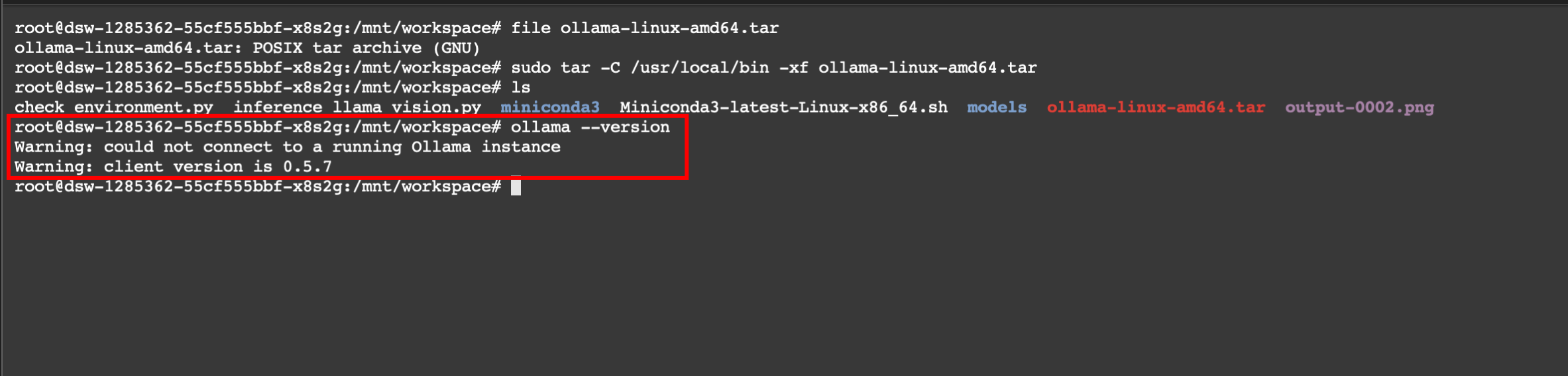

官网提供的方式在国内下载很慢,可以考虑查看 Linux 内核,进入 Ollama Releases 页面 下载对应 Linux 内核的版本,上传服务器解压安装。

sudo tar -C /usr/local/bin -xf ollama-linux-amd64.tar

验证安装

# 检查 Ollama 版本

ollama --version

# 启动 Ollama 服务

ollama serve

2. 下载 GGUF 模型

使用 Ollama 拉取

# 拉取 Llama 3.2 Vision 模型

ollama pull llama3.2-vision:11b

# 验证模型下载

ollama list

3. 验证部署

基本验证流程

# 第一步:启动 Ollama 服务

ollama serve

# 第二步:检查 Ollama 版本(确保 >= 0.3.0)

ollama --version

# 第三步:下载模型

ollama pull llama3.2-vision:11b

# 第四步:验证模型安装

ollama list

# 第五步:测试基本功能

ollama run llama3.2-vision:11b "你好,请用中文介绍一下你自己的能力"

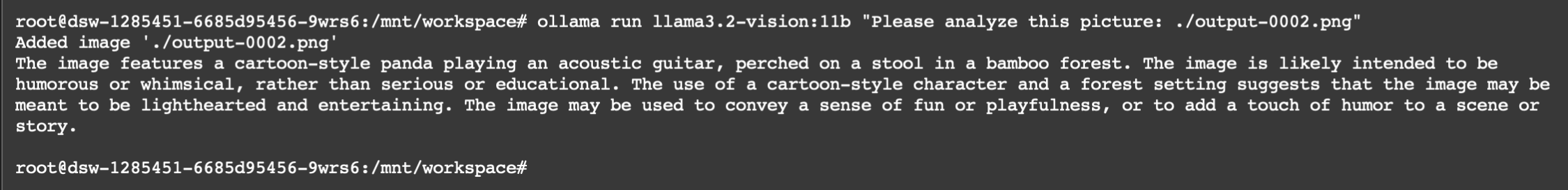

测试图像理解功能

ollama run llama3.2-vision:11b "Please analyze this picture: ./images_path"

验证结果示例

ollama run llama3.2-vision:11b "Please analyze this picture: ./output-0002.png" # 输入命令

运行结果: